Automatische Übersetzung ohne menschliche Beteiligung – ist das möglich? Die Entwicklungen im Bereich der maschinellen Übersetzung (MÜ) sind beeindruckend. KI-gestützte Systeme liefern mittlerweile erstaunlich gute Ergebnisse und haben die Art und Weise, wie wir mit Übersetzungen umgehen, grundlegend verändert. Es ist daher verständlich, dass manche in der Branche von einer Zukunft träumen, in der Übersetzungen vollautomatisch und fehlerfrei ablaufen – quasi wie autonome Shuttles, die uns am Flughafen zum Gate bringen.

Doch so verlockend diese Vorstellung auch sein mag, sollten wir realistisch bleiben. Die MÜ hat in den letzten Jahren zwar enorme Fortschritte gemacht. Doch bis zur vollständigen Automatisierung ist es noch ein weiter Weg. Auch wenn KI-Systeme wie DeepL oder Google Translate beeindruckende Ergebnisse liefern, sind sie noch lange nicht perfekt.

KI und die Komplexität der menschlichen Sprache

Menschliche Sprache und Maschinensprache sind grundlegend unterschiedlich. Während die menschliche Sprache durch Individualität und Persönlichkeitsausdruck geprägt ist, basiert Maschinensprache auf Zahlen und Algorithmen. Jeder Mensch hat seine eigene Ausdrucksweise, die von persönlichen Erfahrungen, Gefühlen und dem individuellen Verständnis geprägt ist. Was jemand ausdrückt, ist oft stark von seiner Indentität und Persönlichkeit beeinflusst, was er sieht, versteht, für wichtig hält und was er fühlt.

Darüber hinaus spielen die in einer Sprache verfügbaren Wörter und Begriffe eine entscheidende Rolle. Was man sich zum Beispiel als Verkehrsmittel in London und in Malis Hauptstadt Bamako vorstellt, ist sehr unterschiedlich. Manche Ideen sind in bestimmten Sprachen schwer zu vermitteln oder werden unterschiedlich verstanden. Dies kann zu Missverständnissen führen, die für eine Übersetzungsengine schwer zu erkennen und zu korrigieren sind. Zwar gibt es besonders im professionellen und technischen Bereich Versuche, die Sprache zu standardisieren, wie zum Beispiel durch kontrollierte Sprache und Fachterminologie, doch diese Standards erfassen nicht die gesamte Bandbreite menschlicher Ausdrucksweise.

Neuronale maschinelle Übersetzungssysteme (NMÜ) und Large Language Models (LLMs) verarbeiten Sprache auf eine ganz andere Weise. Sie wandeln Wörter in Zahlen um und generieren Text basierend auf Algorithmen und Datenmodellen. Diese Systeme haben Schwierigkeiten, die vielen Kontexte und Nuancen zu erfassen, die in einer menschlichen Kommunikationssituation entstehen. Die vermittelten Inhalte weichen oft von den gelernten typischen Kontexten ab, was zu Übersetzungsfehlern führen kann. Maschinen sind ferner nicht in der Lage, die emotionalen und kulturellen Feinheiten zu erkennen, die für eine genaue und bedeutungsvolle Übersetzung notwendig sind. Mehr zum Thema KI und Sprachverständnis finden Sie in diesem Blogartikel: Große Sprachmodelle: Machen sie Übersetzer und Redakteure überflüssig?

Kontext in der technischen Kommunikation

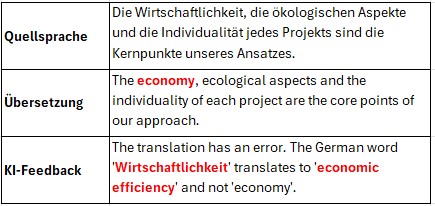

Moderne neuronale maschinelle Übersetzungssysteme sind darauf trainiert, zwischen verschiedenen standardmäßigen Kontexten zu unterscheiden. Während in den Anfangsjahren oft Fehler im Kontext einer Übersetzung auftraten – ein oft zitiertes Beispiel ist die falsche Übersetzung des deutschen Wortes „Bank“ als „bench“ (Möbel) statt „bank“ in einem finanziellen Kontext – sind diese Fehler heute seltener. Moderne Transformer-Modelle [1], insbesondere durch Mechanismen wie Selbstaufmerksamkeit (self attention) [2], liefern bereits sehr gute Ergebnisse in der Kontextualisierung. Sie sind oft in der Lage, komplexe sprachliche Zusammenhänge zu berücksichtigen. Dennoch sollte man nicht unterschätzen, dass die Verwendung von Fachbegriffen im technischen Bereich besondere Herausforderungen mit sich bringt.

Technische Verfahren können je nach Maschine oder Modell unterschiedlich sein. Ein Beispiel ist das Wort „schneiden“, das sowohl das Schneiden mit einem Messer als auch mit einem Laserstrahl bedeuten kann, was sehr unterschiedliche Übersetzungen wie „cutter“ bzw. „beamer“ erfordert. Dies gilt für viele Komposita, die auf Handlungsverben basieren, wie z.B. „Hebezeug“. Eine Hebevorrichtung kann ein einfacher Flaschenzug oder ein Hubtisch sein, was in der Übersetzung präzisiert werden muss.

Auch technische Komponenten können unterschiedliche Eigenschaften haben, die in Fremdsprachen unterschiedlich zu übersetzen sind. Man denke an die verschiedenen Formen und Größen von Behältern: Ein „Behälter“ oder ein „Gebinde“ kann in der deutschen Sprache viele Formen annehmen, von einem einfachen Plastikbehälter bis zu einem großen Frachtcontainer. In anderen Sprachen können dafür unterschiedliche Begriffe verwendet werden, die jeweils die spezifische Form oder Funktion des Behälters berücksichtigen.

Die großen Datenmodelle, sowohl NMÜ als auch Large Language Models (LLM), berücksichtigen hauptsächlich die typischen Kontexte, die sie aus großen Datenmengen gelernt haben. Insbesondere bei innovativen Unternehmen, die neue Verfahren und Produkte einführen, kann eine automatische Übersetzung aufgrund der spezifischen und firmenindividuellen Fachsprache manchmal zu Fehlern führen. Diese speziellen Kontexte sind oft nicht ausreichend in den Trainingsdaten vertreten, was zu ungenauen oder missverständlichen Übersetzungen führen kann.

Deshalb ist es auch im technischen Bereich unerlässlich, die Ergebnisse von KI-Übersetzungen sorgfältig zu prüfen und bei Bedarf Fachleute hinzuzuziehen, um sicherzustellen, dass die Übersetzungen präzise und kontextgerecht sind.

Wissen und Verstehen

Automatische Übersetzungssysteme und LLMs besitzen kein Wissen und kein Verstehen im menschlichen Sinne. Sie verarbeiten zwar enorme Mengen an Daten und können daraus Muster erkennen, aber sie organisieren diese Informationen nicht logisch und verstehen nicht die zugrunde liegenden Zusammenhänge. Sie wissen nicht, welche Voraussetzungen erfüllt sein müssen, um ein bestimmtes Verfahren zu einem spezifischen Ziel zu führen, welche einzelnen Schritte notwendig sind und welche Faktoren den Prozess beeinflussen.

Bei mehrdeutigen Aussagen und Beschreibungen kann ein Mensch, insbesondere ein Techniker oder eine Fachfrau im Bereich der technischen Kommunikation, den tatsächlichen Sinn erkennen und Fehlinterpretationen vermeiden. Maschinen hingegen sind in solchen Situationen oft überfordert, da sie den Kontext nicht vollständig erfassen können.

Ein Beispiel dafür ist die technische Beschreibung eines Verfahrens wie das „Löten“ in der Elektronikfertigung. Ein Mensch, der mit den Prozessen vertraut ist, wird sofort erkennen, ob es sich um Weichlöten, Hartlöten oder Reflow-Löten handelt, basierend auf dem restlichen Kontext der Beschreibung. Ein automatisches Übersetzungssystem könnte jedoch Schwierigkeiten haben, diese Unterschiede korrekt zu erfassen und zu übersetzen, da es den praktischen Kontext und die spezifischen Anforderungen der verschiedenen Verfahren nicht versteht.

Fehlende Weltkenntnis von KI-Systemen

Vor allem im Bereich Marketing sind Texte häufig voller Anspielungen und Verweise auf aktuelle oder historische Ereignisse. Sie erwähnen oft öffentliche Personen, seien es Politikerinnen, Künstler oder Sportler, und verwenden Stilmittel wie Ellipsen, Metaphern oder Wortspiele, die von menschlichen Lesern sofort erkannt und verstanden werden. Neuronale maschinelle Übersetzungssysteme und Large Language Models reagieren darauf mit unterschiedlichen Fähigkeiten. LLMs wurden mit sehr großen Textkorpora vortrainiert, die ihnen ein gewisses „Wissen“ über die Welt vermitteln. Sie erkennen also etwas mehr von diesem Weltwissen, haben aber trotz allem unübersehbare Einschränkungen.

Neuronale maschinelle Übersetzungssysteme stoßen dagegen momentan schnell an ihre Grenzen. Diese Systeme haben keine echte Weltkenntnis und können daher die kulturellen und historischen Kontexte, die für das Verständnis solcher Texte notwendig sind, nicht erfassen. Zum Beispiel: Eine amerikanische Webseite verwendet den Slogan „Yes, we can“, eine bekannte Anspielung auf Barack Obamas Wahlkampfslogan. Ein automatisches Übersetzungssystem könnte diesen Satz wörtlich übersetzen, ohne die kulturelle Referenz zu erkennen. Eine wörtliche Übersetzung wie „Ja, wir können“ klingt im Deutschen unnatürlich und verliert den Bezug zur politischen Kampagne. Ein menschlicher Übersetzer würde eine angemessene Übersetzung wählen.

Dieses Beispiel verdeutlicht, warum es entscheidend ist, die Ergebnisse von KI-Übersetzungen im Marketingbereich sorgfältig zu prüfen und sicherzustellen, dass die Übersetzungen die beabsichtigte Bedeutung und den kulturellen Kontext richtig wiedergeben. Menschen können die tiefere Bedeutung und die kulturellen Referenzen in Texten erkennen und entsprechend übersetzen, während Maschinen in diesem Bereich noch eingeschränkt sind.

Inkonsistenz der maschinellen Übersetzung

Man könnte meinen, dass automatische Übersetzungssysteme konsistent arbeiten. Doch dem ist nicht so. Tatsächlich wird jeder übersetzte Satz neu generiert. Die Algorithmen berechnen jedes Wort in Abhängigkeit von den vorangegangenen Wörtern, was regelmäßig zu uneinheitlichen Übersetzungen von Fachbegriffen führt.

Ein Beispiel: In einem technischen Dokument könnte das Wort „repair kit“ einmal als „Reparaturkit“ und ein anderes Mal als „Reparaturset“ übersetzt werden, obwohl es sich um denselben Begriff handelt. Diese Inkonsistenz kann in technischen und wissenschaftlichen Texten zu Verwirrung und Missverständnissen führen.

Zwar bieten einige Systeme wie DeepL die Möglichkeit, Glossare einzubinden, um die Übersetzung spezifischer Fachtermini zu standardisieren, aber das deckt in der Regel nicht alle benötigten Begriffe ab. Zudem berücksichtigen diese Glossare nicht die Möglichkeit von Homonymen – Wörter, die gleich geschrieben werden, aber unterschiedliche Bedeutungen haben. Ein Beispiel hierfür ist das Wort „Schalter“, das sowohl „switch“ als auch „tag (im Softwarecode)“ bedeuten kann. Ohne den richtigen Kontext können diese Begriffe falsch übersetzt werden.

Diese Inkonsistenzen sind besonders problematisch in Bereichen, die eine hohe Präzision und Einheitlichkeit erfordern, wie technische Dokumentationen, medizinische Berichte oder juristische Texte. In solchen Fällen ist es entscheidend, dass Fachbegriffe konsequent und stets korrekt übersetzt werden, um Verwirrung und potenziell schwerwiegende Fehler zu vermeiden.

Fehlerhafte Umsetzung formeller Aspekte durch MÜ-Systeme

Auch bei formellen Aspekten, die eigentlich wenig Interpretationsspielraum lassen, könnte man meinen, dass neuronale maschinelle Übersetzungssysteme (NMÜ) oder Large Language Models (LLMs) besonders verlässlich sind. Dennoch treten immer wieder Fehler auf, die die Genauigkeit und Zuverlässigkeit der Übersetzungen beeinträchtigen können.

Ein häufiges Problem ist die fehlerhafte Übertragung von Zahlen. In technischen Dokumenten, Verträgen oder wissenschaftlichen Arbeiten können schon kleine Fehler bei Zahlen zu großen Missverständnissen und Problemen führen. Beispielsweise kann eine falsche Dezimalstelle oder das Vertauschen von Tausendertrennzeichen gravierende Folgen haben.

Auch bei der Interpunktion sind Fehler nicht selten. Falsch gesetzte oder fehlende Satzzeichen können den Sinn eines Satzes verändern (“Wir essen [,] Opa”) oder ihn unverständlich machen. Besonders in komplexen Sätzen, wo die richtige Platzierung von Kommas und Punkten entscheidend ist, versagen automatische Systeme manchmal.

Ein weiteres häufiges Problem ist die Übersetzung von Eigennamen. Während menschliche Übersetzer wissen, dass Eigennamen in der Regel nicht übersetzt werden sollten, haben Maschinen hier manchmal Schwierigkeiten. So kann es passieren, dass Namen von Personen, Orten oder Marken ungewollt übersetzt werden, was zu Verwirrung führt.

Darüber hinaus kommt es vor, dass Teile eines Satzes vergessen oder hinzugefügt werden. Solche Fehler können schwerwiegende Konsequenzen haben.

Diese Fehler bei formellen Aspekten verdeutlichen, dass NMÜ-Systeme und LLMs trotz aller Fortschritte noch weit davon entfernt sind, fehlerfreie Ergebnisse zu liefern.

Fortlaufende Entwicklung bei automatischen Übersetzungen und KI

Die Modelle der maschinellen Übersetzung lernen kontinuierlich weiter und werden tendenziell besser. Eine interessante Entwicklung in diesem Bereich ist die Kombination zweier Ansätze: neuronale maschinelle Übersetzung (NMÜ) und Large Language Models (LLMs). Beide Systeme können übersetzen. Aber besonders ihre Kombination kann Vorteile bringen. LLMs wie GPT-4 haben eine begrenzte Fähigkeit, menschliches Verstehen nachzubilden. Sie können daher insbesondere im Bereich des automatischen Post-Editing eingesetzt werden, um bestimmte Fehler von NMÜ-Systemen zu erkennen und zu korrigieren.

Trotz ihrer unterschiedlichen Anwendungsbereiche gehören beide Ansätze zur selben Produkt- und Methodenfamilie. Sie teilen ähnliche Methoden und Infrastrukturen. NMÜ-Systeme basieren auf dem Transformer-Modell mit einem Encoder-Decoder-Ansatz, während LLMs auf dem Transformer-Modell mit einem Decoder-Ansatz beruhen. Diese gemeinsame Grundlage ermöglicht es, dass Fortschritte in einem Bereich häufig auch positive Auswirkungen auf den anderen Bereich haben.

Zum Beispiel können LLMs dabei helfen, die kontextuelle Kohärenz und die semantische Präzision zu verbessern, indem sie Fehler identifizieren, die durch NMÜ-Systeme gemacht werden. Sie können auch dabei helfen, die Konsistenz zu wahren, indem sie die Übersetzungen von Fachbegriffen und Phrasen überprüfen und standardisieren.

Dennoch gibt es nach wie vor erhebliche Herausforderungen. Beide Systeme teilen grundlegende Schwächen, wie das Fehlen eines tiefen Verständnisses, das logische Beziehungen in Aussagen nachvollziehen kann, und das Fehlen von Weltwissen. Fortschritte in der Technologie und Methodik führen zwar zu Verbesserungen, aber die grundlegenden Einschränkungen bleiben bestehen. Es ist daher entscheidend, die Ergebnisse dieser Systeme weiterhin kritisch zu prüfen und bei Bedarf menschliches Fachwissen hinzuzuziehen.

Fazit

Neuronale maschinelle Übersetzungssysteme (NMÜ) und Large Language Models (LLMs) werden zunehmend in der Übersetzungsproduktion eingesetzt. KI-Systeme übernehmen immer größere Teile der Übersetzungsarbeit, beschleunigen den Prozess und senken die Kosten. Dennoch ist es wichtig, die Grenzen dieser Technologien zu erkennen, da sie im korrekten Verständnis des Übersetzungsinhalts eingeschränkt sind. Fehlerfreie Übersetzungen sind ein hochgestecktes Ziel, das diese Systeme wahrscheinlich nie vollständig erreichen werden. Daher ist es entscheidend, die Ergebnisse von KI-Übersetzungen stets kritisch zu prüfen und menschliches Fachwissen hinzuzuziehen, um Missverständnisse und Fehler zu vermeiden.

Die Zukunft der Übersetzung liegt in der Zusammenarbeit von Mensch und Maschine.

[1] Ein Transformer-Modell ist eine Architektur des maschinellen Lernens, die auf dem Mechanismus der Selbstaufmerksamkeit („self attention“ [2] = Gewichtete Beziehungen innerhalb einer Sequenz) basiert. Es analysiert sequentielle Eingabedaten, wie beispielsweise Text, indem es die Beziehungen zwischen den einzelnen Elementen (z. B. Wörtern) gewichtet und so den Kontext und die Bedeutung jedes Elements innerhalb der Sequenz besser erfasst.